llama.cpp ist eine Open-Source-Softwarebibliothek, die größtenteils in C++ geschrieben ist und Inferenzen auf verschiedenen Large Language Models wie Llama durchführt. Ein CLI und ein Webserver sind in der Bibliothek enthalten. llama.cpp wurde zusammen mit dem GGML-Projekt entwickelt, einer allgemeinen Tensor-Bibliothek.

Das Modell Phi3 verwendet eine Kombination aus quantitativen und qualitativen Methoden, um eine umfassende Risikobewertung zu ermöglichen. Dabei werden sowohl finanzielle als auch nicht-finanzielle Aspekte berücksichtigt.

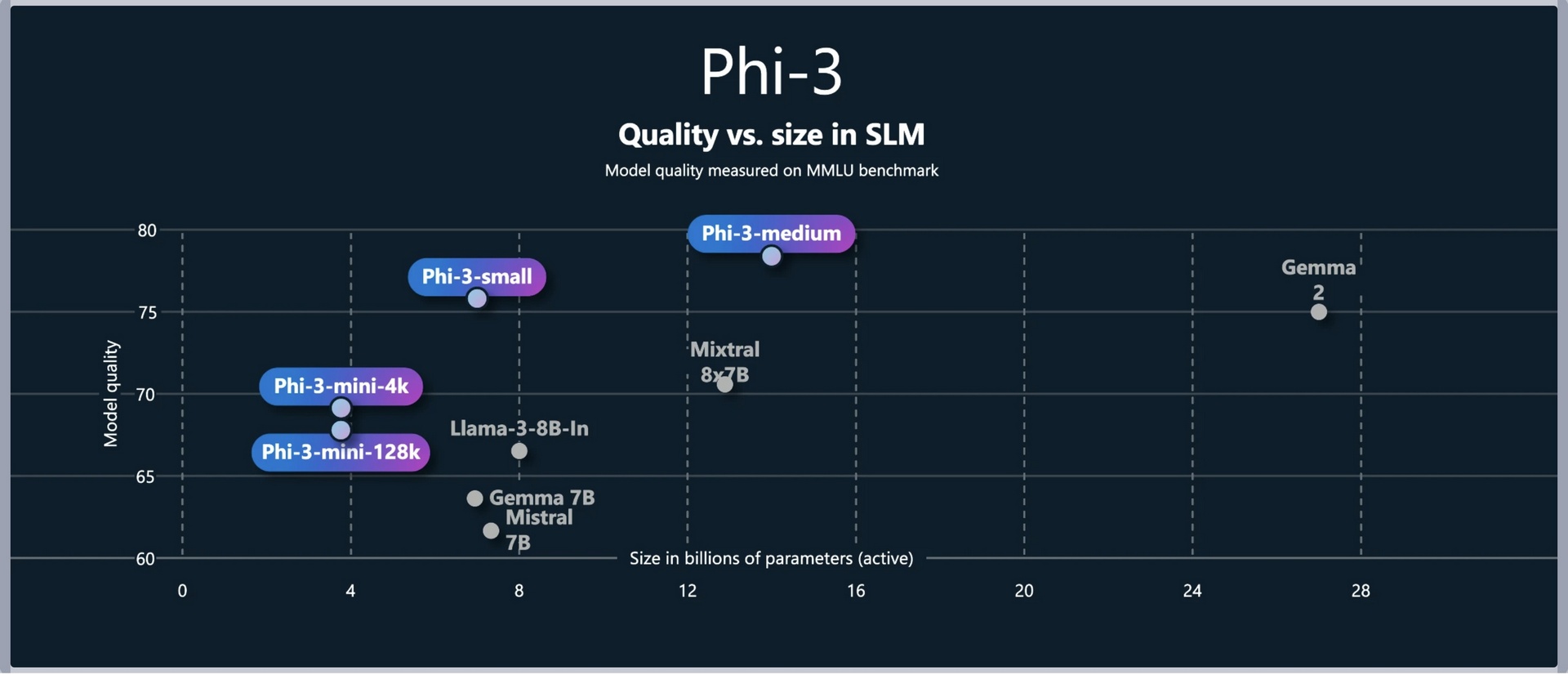

The Phi-3-small model, with only 7B parameters, has demonstrated superior performance over GPT-3.5T across various language, reasoning, coding, and...

Phi-3-small achieves superiority.

llama.cpp bietet volle Kontrolle und höhere Datensicherheit

Niedrigere Betriebskosten: Reduzieren Sie laufende Kosten durch den Einsatz vorhandener Infrastruktur.

Volle Datenkontrolle: Verwalten Sie KI-Modelle intern, um sensible Daten nicht an externe Cloud-Dienste zu senden.

Compliance sicherstellen: Erfüllen Sie Datenschutzbestimmungen, indem Sie Daten innerhalb Ihres eigenen Netzwerks verarbeiten.

Kosteneffizient arbeiten: Keine teure Hardware nötig - llama.cpp ermöglicht den Betrieb auf CPU-basierten Servern. wodurch Investitionen in GPUs entfallen.

Reduzieren Sie laufende Kosten durch den Einsatz vorhandener Infrastruktur

Unsere Aufgabe wird durch die Nutzung einer On-Premise-Lösung und der ChatGPT-Cloud gelöst. Diese Kombination ermöglicht eine effiziente und maßgeschneiderte Lösung für unsere Anforderungen.

Wir möchten demonstrieren, wie man mit llama.cpp eine Känguru Mathematik Aufgabe 11-13 Klasse lösen kann.

Wir haben dazu einen Docker-Container auf On-Premise Basis aufgebaut. Wir zeigen hier, wie man eine Infrastruktur aufbauen kann.

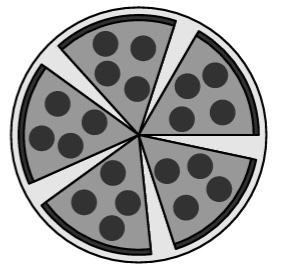

Die Mathematik-Aufgabe aus Känguru 2024 ist für die Klassenstufen 11 bis 13 konzipiert und bietet anspruchsvolle Herausforderungen für Schülerinnen und Schüler in diesen Jahrgangsstufen.

Mattis hat eine Pizza in sechs gleich große Stücke geschnitten. Nachdem er ein Stück gegessen hat, ordnet er die restlichen Stücke so an, dass die Lücken zwischen benachbarten Stücken alle gleich groß sind. Wie groß ist jeweils der Winkel, den zwei benachbarte Stücke einschließen?

Mit der steigenden Nachfrage nach leistungsfähigen Sprachmodellen suchen viele Unternehmen nach Möglichkeiten, diese sicher und effizient on-premise zu betreiben. llama.cpp bietet eine Open-Source-Lösung für die Ausführung von großen Sprachmodellen auf eigener Hardware. In diesem Artikel erfahren Sie, wie Sie llama.cpp unter Docker betreiben können, um maximale Datensicherheit zu gewährleisten, und welche Alternativen es gibt.

Link vom Modell, proejkt seite

update

Managing Consultant

Security Advisor